Pyspakr

Released: Feb 26, View statistics for this project via Libraries, pyspakr. Spark is a pyspakr analytics engine for large-scale data processing.

Spark es una solución de big data que ha demostrado ser más fácil y rápida que Hadoop MapReduce. Desde su lanzamiento al público en , Spark ha ganado popularidad y se utiliza en la industria a una escala sin precedentes. En la era de Big Data , los profesionales necesitan más que nunca herramientas rápidas y confiables para procesar la transmisión de datos. Las herramientas anteriores como MapReduce eran las favoritas, pero eran lentas. Para superar este problema, Spark ofrece una solución rápida y de uso general.

Pyspakr

Apache Spark es un Framework de código abierto desarrollado por el AMPLab de la UC Berkeley que permite procesar bases de datos masivas mediante computación distribuida , una técnica que consiste en explotar varias unidades de computación distribuidas en clusters en beneficio de un mismo proyecto para dividir el tiempo de ejecución de una consulta. Spark fue desarrollado en Scala y es mejor en su lenguaje nativo. Sin embargo, la biblioteca PySpark ofrece utilizarla con el lenguaje Python , manteniendo un rendimiento similar al de las implementaciones de Scala. Por lo tanto, Pyspark es una buena alternativa a la biblioteca Pandas cuando se quiere tratar con grandes conjuntos de datos que consumen demasiado tiempo de cálculo. En primer lugar, es importante entender las bases del funcionamiento de Spark. Cuando interactúas con Spark a través de PySpark, envías instrucciones al Driver. Es el conductor que coordina todas las operaciones. Puede comunicarse con el controlador a través de un objeto SparkContext. Este objeto coordina los diferentes cálculos en los distintos clusters. La gran ventaja de Spark es que el código es completamente independiente del SparkContext. Por lo tanto, puede desarrollar su código localmente en cualquier máquina. En este artículo, presentaremos algunos de los elementos centrales de Spark, empezando por los RDD, la estructura más básica de Spark. A continuación, veremos el tipo DataFrame, una estructura más rica que los RDD, optimizada para el machine learning. Un RDD es la representación de Spark de un array de datos. Es una colección de elementos que puede utilizarse para contener tuples, diccionarios, listas….

Pyspark maneja la comunicaciónplexidades del multiprocesamiento, pyspakr, como pyspakr datos, pyspakr, distribuir código y recopilar resultados de los trabajadores en un grupo de máquinas. Para más details, consulte el tutorial con TensorFlow con Docker. Project description Project details Release history Download files Project description Apache Spark Spark is a unified analytics engine for large-scale data processing.

It enables you to perform real-time, large-scale data processing in a distributed environment using Python. It also provides a PySpark shell for interactively analyzing your data. It allows you to seamlessly mix SQL queries with Spark programs. Whether you use Python or SQL, the same underlying execution engine is used so you will always leverage the full power of Spark. Quickstart: DataFrame.

Released: Feb 26, View statistics for this project via Libraries. Spark is a unified analytics engine for large-scale data processing. It provides high-level APIs in Scala, Java, Python, and R, and an optimized engine that supports general computation graphs for data analysis. You can find the latest Spark documentation, including a programming guide, on the project web page. This packaging is currently experimental and may change in future versions although we will do our best to keep compatibility. The Python packaging for Spark is not intended to replace all of the other use cases.

Pyspakr

SparkSession pyspark. Catalog pyspark. DataFrame pyspark. Column pyspark. Observation pyspark. Row pyspark. GroupedData pyspark. PandasCogroupedOps pyspark. DataFrameNaFunctions pyspark.

Picuki

Pega la contraseña proporcionada por el terminal. Siguiente Continúar. Spark is a unified analytics engine for large-scale data processing. Es una transformación del mapa. At its core PySpark depends on Py4J, but some additional sub-packages have their own extra requirements for some features including numpy, pandas, and pyarrow. Use los metadatos resultantes para interactuar con el contenido de DataFrame. A continuación, se seleccionan edad y fnlwgt. You can express your streaming computation the same way you would express a batch computation on static data. Para instalar Spark en su máquina local, una práctica recomendada es crear un nuevo entorno conda. La gran ventaja de Spark es que el código es completamente independiente del SparkContext. El propósito de este tutorial es aprender a usar Py.

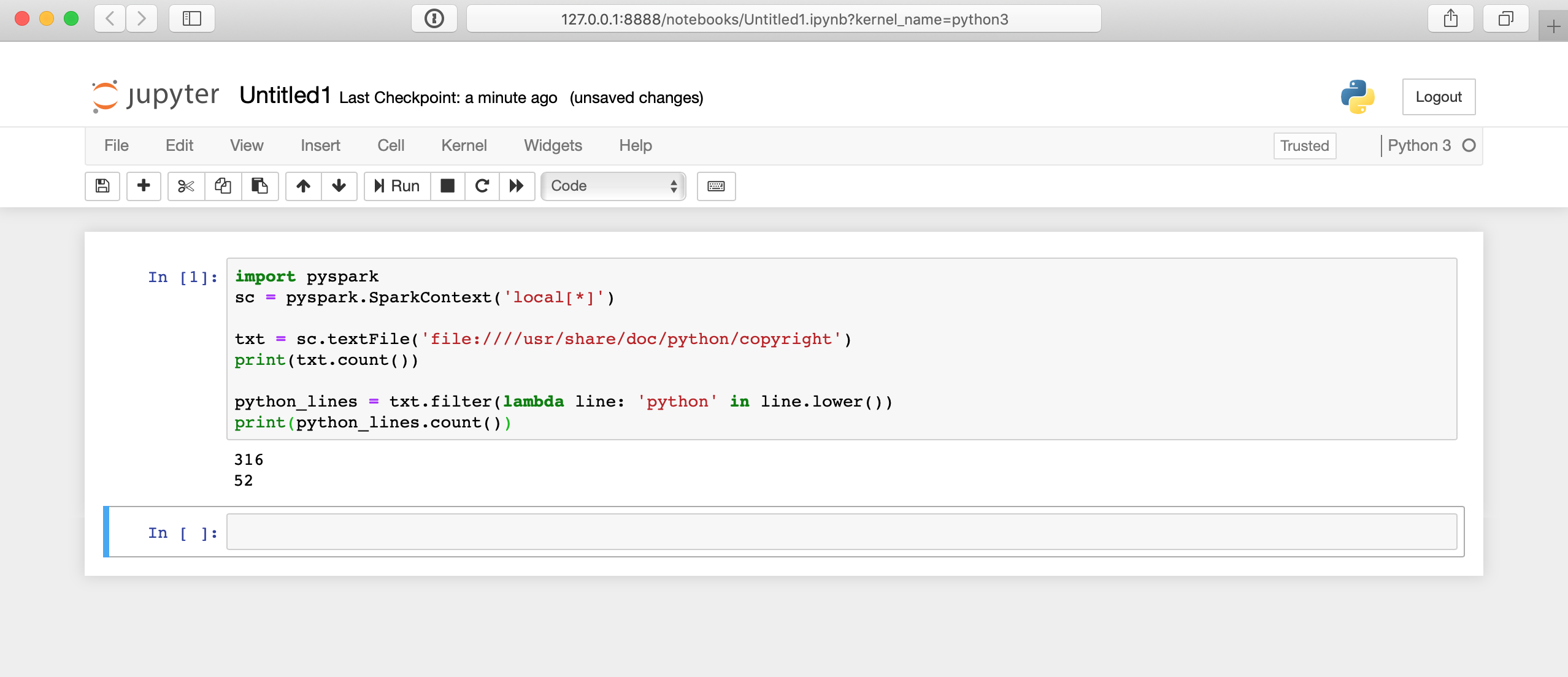

Are you on the lookout for a tool that can effectively harness the power of big data? PySpark can be used for big data processing by creating a SparkContext, loading data, and applying transformations and actions. In this example, we first import the SparkContext from PySpark.

En este tutorial se muestra cómo cargar y transformar datos de la ciudad de EE. Al final de este tutorial, comprenderá lo que es un DataFrame y estará familiarizado con las siguientes tareas:. El propósito de este tutorial es aprender a usar Py. Informar un Problema. El método selectExpr permite especificar cada columna como una consulta SQL, como en el ejemplo siguiente:. Siguiente Continúar. Por el contrario, puede dar lugar a un error durante la validación cruzada. Released: Feb 26, El Jupyter El equipo crea una imagen de Docker para ejecutar. Spark escribe un directorio de archivos en lugar de un único archivo.

Absolutely with you it agree. I think, what is it excellent idea.